Nilalaman

T:

Bakit madalas na mahirap sanayin ang mga artipisyal na paulit-ulit na neural network?

A:

Ang kahirapan sa pagsasanay ng mga artipisyal na paulit-ulit na neural network ay may kinalaman sa kanilang pagiging kumplikado.

Ang isa sa mga pinakasimpleng paraan upang maipaliwanag kung bakit ang mga paulit-ulit na neural network ay mahirap sanayin na hindi sila feedforward neural network.

Sa mga network ng feed ng neural, lumilipat lamang ang mga signal sa isang paraan. Ang signal ay gumagalaw mula sa isang layer ng input sa iba't ibang mga nakatagong layer, at pasulong, sa output layer ng isang sistema.

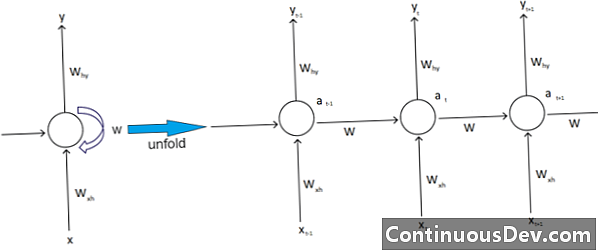

Sa kabaligtaran, ang paulit-ulit na mga network ng neural at iba pang iba't ibang uri ng mga neural network ay may mas kumplikadong mga paggalaw ng signal. Na-uri bilang mga "feedback" network, ang paulit-ulit na mga network ng neural ay maaaring magkaroon ng mga senyas na naglalakbay nang pasulong at pabalik, at maaaring maglaman ng iba't ibang mga "mga loop" sa network kung saan ang mga numero o mga halaga ay naipabalik sa network. Inuugnay ito ng mga eksperto sa aspeto ng paulit-ulit na mga network ng neural na nauugnay sa kanilang memorya.

Bilang karagdagan, ang iba pang uri ng pagiging kumplikado na nakakaapekto sa paulit-ulit na mga network ng neural. Ang isang napakahusay na halimbawa nito ay sa larangan ng pagproseso ng natural na wika.

Sa sopistikadong natural na pagproseso ng wika, kailangang maalala ng mga neural network ang mga bagay. Kailangan ding kumuha ng mga input sa con, masyadong. Ipagpalagay na mayroong isang programa na nais na pag-aralan o mahulaan ang isang salita sa loob ng isang pangungusap ng iba pang mga salita. Maaaring, halimbawa, isang nakapirming haba ng limang salita para masuri ang system. Nangangahulugan ito na ang network ng neural ay kailangang magkaroon ng mga input para sa bawat isa sa mga salitang ito, kasama ang kakayahang "alalahanin" o sanayin sa con ng mga salitang ito. Para sa mga at iba pang katulad na mga kadahilanan, ang paulit-ulit na mga network ng neural ay karaniwang may mga maliit na nakatagong mga loop at puna sa system.

Ang mga eksperto ay naglulungkot na ang mga komplikasyon na ito ay ginagawang mahirap sanayin ang mga network. Ang isa sa mga pinaka-karaniwang paraan upang maipaliwanag ito ay sa pamamagitan ng pagbanggit ng pagsabog at nawawala na problema ng gradient. Mahalaga, ang mga timbang ng network ay maaaring humantong sa pagsabog o mawala na mga halaga na may isang malaking bilang ng mga pumasa.

Ipinapaliwanag ng payunir sa network ng Neural na si Geoff Hinton ang hindi pangkaraniwang bagay na ito sa web sa pamamagitan ng pagsasabi na ang mga paatras na linear pass ay magdudulot ng mas maliit na mga timbang na pag-urong nang malaki at mas malaking timbang na sumabog.

Ang problemang ito, nagpapatuloy siya, ay nagkakasala sa mga mahabang pagkakasunud-sunod at maraming mga hakbang sa oras, kung saan lumalaki o nabubulok ang mga signal. Ang pagsisimula ng timbang ay maaaring makatulong, ngunit ang mga hamon na ito ay binuo sa paulit-ulit na modelo ng neural network. Ang mga Theres ay palaging magiging isyu na nakakabit sa kanilang partikular na disenyo at pagbuo. Mahalaga, ang ilan sa mga mas kumplikadong mga uri ng mga neural network ay talagang sumisira sa aming kakayahang madaling pamahalaan ang mga ito. Maaari kaming lumikha ng isang praktikal na walang katapusan na dami ng pagiging kumplikado, ngunit madalas naming nakikita ang paglaki ng mahuhulaan at scalability.